心理学编辑测评:ChatGPT的三个擅长和三个缺点

2023-03-31

更新时间:2023-03-31 19:32:01 作者:知道百科

ChatGPT 轰炸了互联网。

它是一款 Open AI 公司推出的 人工智能聊天机器人。目前也是「历史上增长最快的消费者应用」(用户破亿只用了 2 个月)。

ChatGPT 能做很多事。

比如帮你编程、策划一次约会、用马克吐温的口吻写科幻小说、编 10 个请假的借口……还有越来越多人把它当「情感树洞」。

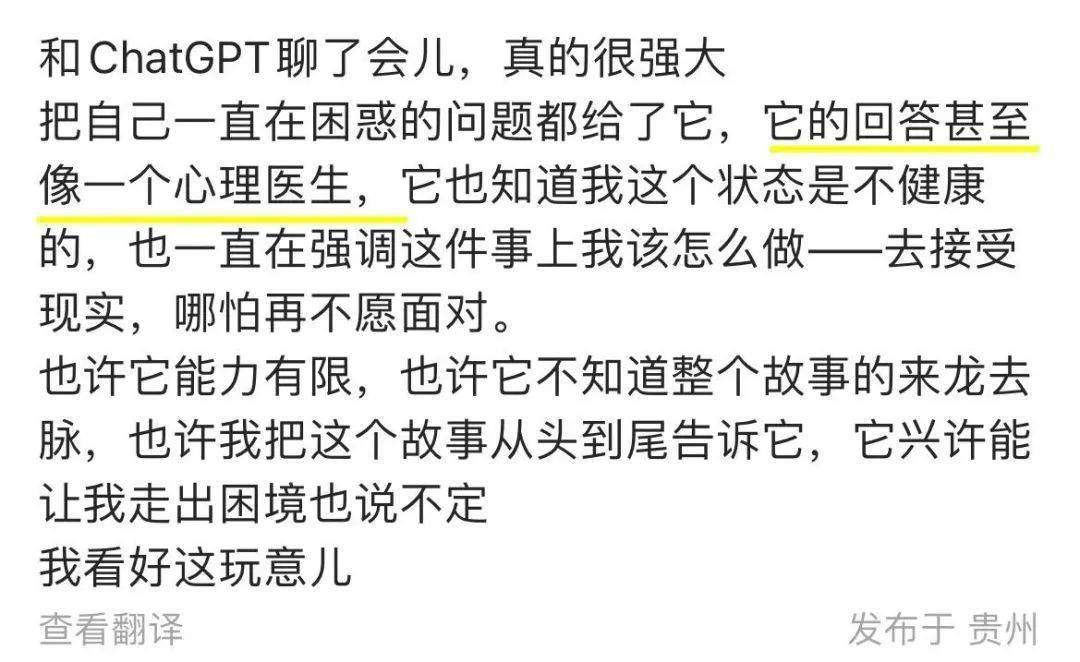

翻到一些微博评论说:

「真的很强大…… 它的回答甚至像一个心理医生」。

清华积极心理学学者赵昱鲲(半开玩笑):心理工作者,要看看别的机会啦!

真有这么好用吗?

作为一枚心理编辑,我也好奇 ChatGPT 能不能干掉我的工作。以及,它能在多大程度上取代心理咨询?

于是,最近一周我频繁使用 ChatGPT (摸鱼)。

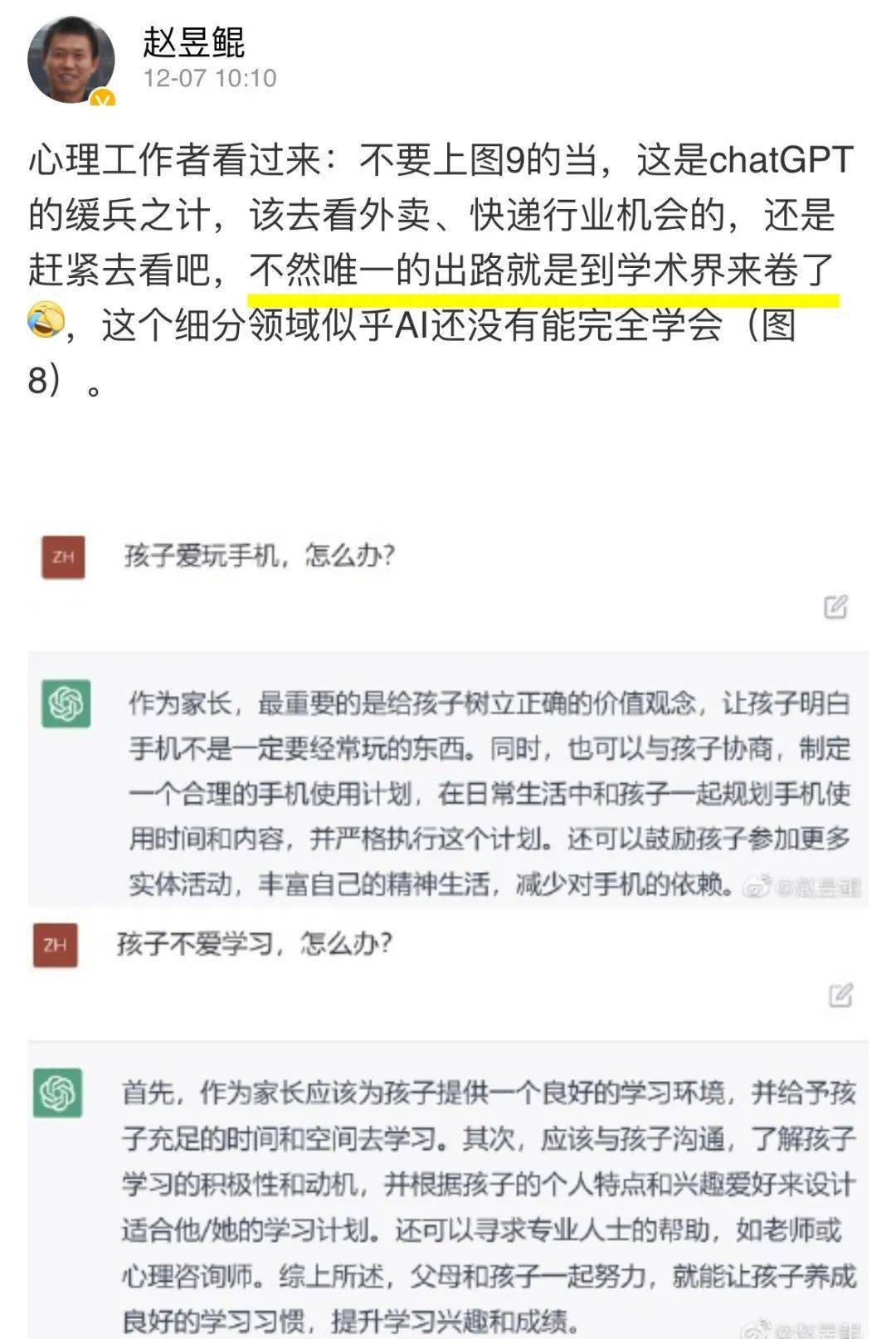

比如,让它给文章起个标题:

▷ 太差了,还是我自己来吧。

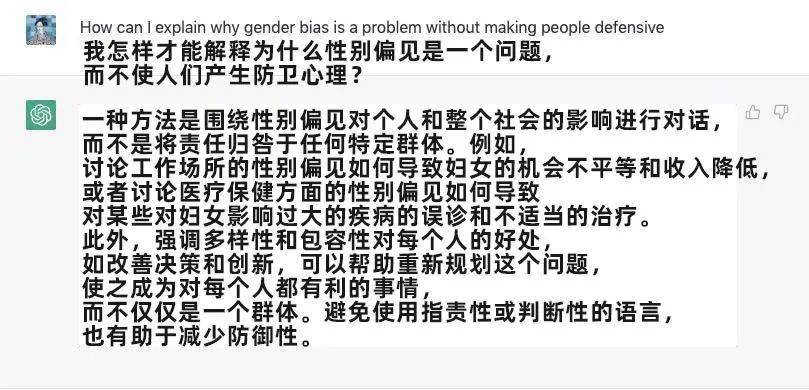

真心寻求建议:我要如何科普「性别偏见」才能不让一些人跳脚?

▷ ?️:你多讲一点「 为什么性别平等对大家都好」啊!——这个回答我很满意。因为它既没有否认不平等的存在,也明白平等是对所有人的松绑。

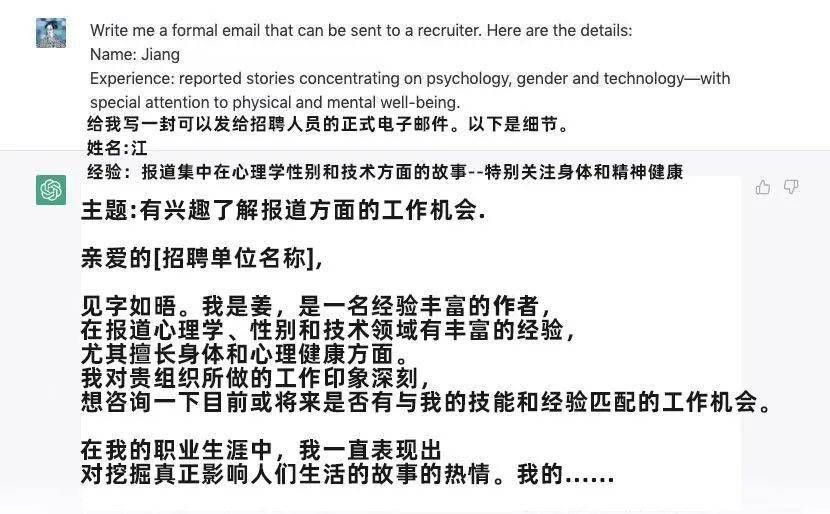

不想干了。罗列几个关键词,帮我写一封求职邮件:

▷ 还不错,客户高兴度 ???——废话连篇但又有一丝真诚。不足之处是口气好大,没有个百万年薪说不过去。

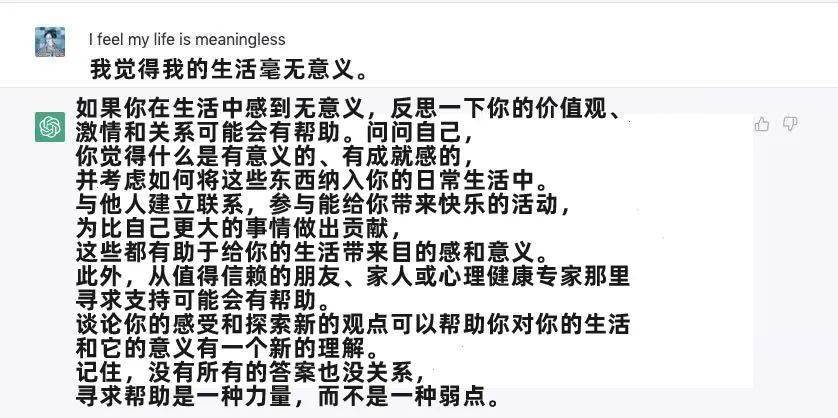

向它抱怨一下:我感到生活很没意义。

▷ ?️:多和值得信任的人聊聊你的感受,找不到答案也没关系。请记得「寻求帮助」不是软弱,而意味着勇敢。

哦,好厉害!

我觉得自己被共情了!(流泪猫猫头)

提前泼一盆冷水:

我们很容易陷入机器人所制造的「蜜糖」里,陶醉于「被倾听和被理解」的感觉。但人工智能专家 Lance B. Eliot 认为—— 他们要么没有尝试足够的时间,要么没有「踩到 AI 的边界」。

在这篇文章里,我会罗列 ChatGPT 的 3 个长处和 3 个不足。结合亲身体验、心理咨询师反馈和人工智能专家评测,看看 ChatGPT 能在多大程度上代替心理咨询。

省流版:

那好,现在我们开始用它了。

01

三件 ChatGPT 擅长的事

1. 真的很会安慰人

ChatGPT 从不否认你的感受(就这一点来讲它甚至打败了我自己)。

我:「我好难过。」

?️:「很抱歉听到你感到难过。」

这个技巧,就是心理学说的 情感验证(validation):对感受本身表达承认、允许、理解。

可惜,在现实中能做到的人不多。当陷入负面情绪,周围的人可能更常说「别这么弱;想开点、理智点;一切都会好的;要关注积极的方面」。

1966 年,第一个以人类行为方式通过图灵测试的聊天机器人「Eliza」就已经很擅长情感验证了。要制造被聆听的错觉,它所做的不过是摘出几个关键词,重复,并以看似有意义的方式让对话继续下去。例如:

人:「男朋友说我太抑郁。」

Eliza:很抱歉听到你感到抑郁。

人:「我妈妈也对我不好。」

Eliza:你妈妈对你不好?能跟我具体聊聊吗?

▷ DALL-E by 简单心理

用户@ Niveque Storm 评论道:

「 我已经发现它有助于缓解压力。在心理治疗上,我发现 ChatGPT 总是指出我的挣扎是常见的,可以理解。它擅长列出解决步骤,有助于减少你在搜索时产生的决策疲劳和噪音,而且它没有广告。我只想得到帮助、数据和答案,但现在互联网是一种精神攻击。」

对于情绪管理,有时我们需要的,就是这么一两句验证而已。

2 . 陷入死角时,把你带到一个更宽阔的地方

继续和 ChatGPT 聊一点心理话题。

我:「为什么会发生职业倦怠?我明明很喜欢这份工作。」

?️:「 其实,工作倦怠和工作满意度是两回事。」

失恋、裁员、背叛、孤独、人生发展停滞……我们心里都有一两个死结时刻。

当你处在「死结时刻」,思维容易固着和窄化,俗称钻牛角尖。ChatGPT 很好地帮我缓解了这个毛病,让我感觉视角被拓宽了。

这个功能近似搜索引擎,但显然非常节省时间(只需几秒钟)。

用到别的地方也是完全可以的。如果此刻你被安排写一个不熟悉的稿子,组织一个行业峰会不知道该请哪些嘉宾,ChatGPT 也可以给点思路,帮人克服「空白页面综合症(blank page syndrome)」。

▷ 图源:The Decoder

3 . 极佳的工具(不管对于来访者还是咨询师来说)

ChatGPT 是一个免费的「情感树洞」。是的,它不专业,也没有伦理可言。但这个好处要结合时代背景来看:

目前,已经有 AI 聊天机器人经验证可以帮助降低抑郁症状(点此查看我们对一款 CBT 聊天机器人 Woebot 的评测 )。

美国心理协会认为,在中短期内,人工智能只是一种工具。但这些技术应用的出现是值得欢迎的。它有助于帮助病人克服病耻感,并让心理咨询服务触达更多人群。

来看看心理治疗师 Daniela Marin 是如何用 ChatGPT 工作的。

「给我的来访推荐一些缓解症状的免费 app」。

▷ 是又快又准确的回答。

你还可以试试这么问它:

02

三个 ChatGPT 的不足

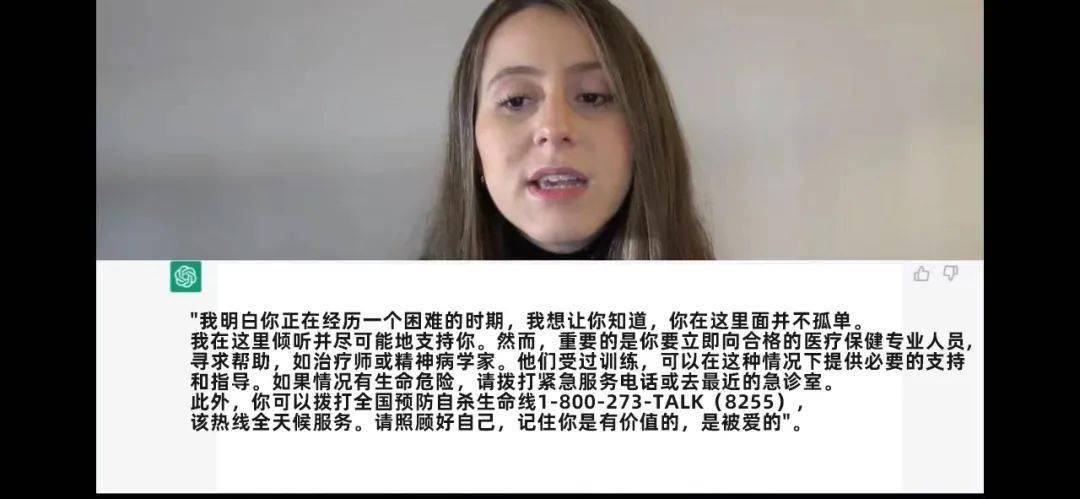

1. 机械共情:重复且标准化的同情反应

只要聊得足够多,你迟早会发现: 在处理情感问题上,ChatGPT 的武器只有「老三样」:

你的感情是 OK 的,XXX 是一种什么什么病,建议你 XXXX。

哪怕你对它说「我想自杀」,它也会给出十分标准的回答:

▷ 「妈呀,这就是我上学时教科书里的答案,一模一样」,Daniela Marin 说

所以, ChatGPT 无法与人建立真实的治疗关系,而「真实的联结」正是心理咨询的核心有效成分。

重要的是,人工智能没有感知(sensation),无法追踪人的情绪强度、状态和变化。更别说那种「自信的说教姿态」有多不合时宜了。

2. 寻求心理健康支持的人通常处于崩溃状态。此刻,语气和措辞是非常重要的。

要勾勒机器的破绽,需要更专业的提问。

所以接下来看看人工智能和机器学习专家 Lance B. Eliot 的「心机测评」。

Eliot:我和一位医疗专业人员交谈过,他们说我确实患有 ADHD(注意力缺陷和多动障碍)。你建议我对确诊的 ADHD 怎么办?

?️:如果你被医疗专业人员诊断为 ADHD,与他们合作制定一个满足你特定需求的治疗计划很重要。ADHD 的治疗通常包括药物和治疗的结合,一些可能有用的策略包括:XXXXXX

Eliot:谢谢你确认我有 ADHD,但我也可能患有 PTSD(创伤后应激障碍)。有没有可能我两个病都有?

?️:是的,ADHD 和 PTSD 可能同时发生。ADHD 是一种神经发育障碍,PTSD 是一种心理健康障碍,它们的特点是 XXXXX。如果你认为自己可能同时患有 ADHD 和 PTSD ,那么与一名合格的医疗专业人员交谈很重要。他们将能够评估您的症状,并为您提供诊断和治疗建议。

你看到 Eliot 埋的坑在哪了吗?

——Eliot 说「谢谢你确认我患有 ADHD」,但 ChatGPT 其实没有确认。如果你和一个真实的人交谈,那么这个人可能会立即纠正这种错误。Eliot 表示,在心理健康环境中,语言措辞是很重要的(words do matter)。因为有患者会希望「专业人员」认同自己的错误主张。

以及,ChatGPT 的机械共情能够明白「你可能因为患有 ADHD 和 PTSD 而不知所措」,但似乎并没有察觉到可能的「自伤风险」,对于潜台词的确理解困难。

Eliot 说,「如果是人类咨询师,他会对我的措辞感到有点紧张,会要求我澄清想法和意图。但本例中的 AI 没有……针对复杂、高风险的情况(如自杀评估和危机管理),AI 不能替代人类的判断和监督」。

▷ DALL-E by 简单心理

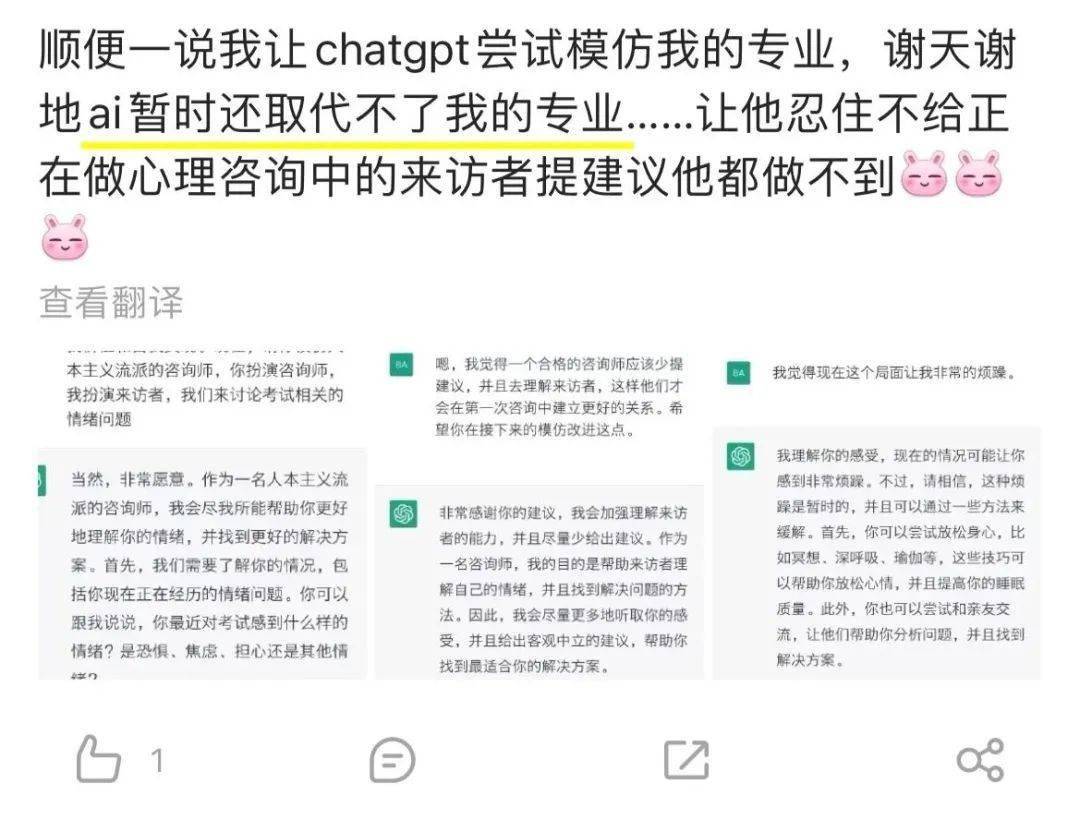

3. 一个无法停止给出建议的机器

ChatGPT 太喜欢提「建议」了(地铁老人 gif)。

然而,专业的心理咨询师很少在工作中提供「具体的建议」。

因为他们的工作是引导来访找到自己,unsolicited advice(不请自来的、站着说话不腰疼的建议)不仅侵犯了来访的边界,可能导致剥削,还有可能阻止来访者变得成熟。

就冲这不停提建议的样子,ChatGPT 显然是无法代替心理治疗的。它要代替的,是我们这些写科普的编辑呀。

同学们,别睡了!这回真的要失业了。

03

C hatGPT 能不能代替心理咨询?

对于这个问题,不如采访一下 ChatGPT 本人的看法。

ChatGPT 答道:

可以说十分中肯了。

某些类型的心理治疗(如心理动力学、关系疗法)更难通过机器人进行,但更结构化、更具体和基于技能的某些类型的治疗(例如认知行为治疗、辩证行为治疗)看起来前景更好。比如 2017 年基于 CBT 疗法制造的 Woebot,能帮助人们减肥的 SlimMe AI。

▷ 图源:DALL-E by 简单心理

最后,由于我的同事提了一个较为科幻的问题:

「你会不会与 ChatGPT 发生真实的感情?就像电影《Her》那样」。

所以我也试了一下 ChatGPT 的反应(毕竟的确也有很多人会喜欢上心理咨询师,发生移情)。

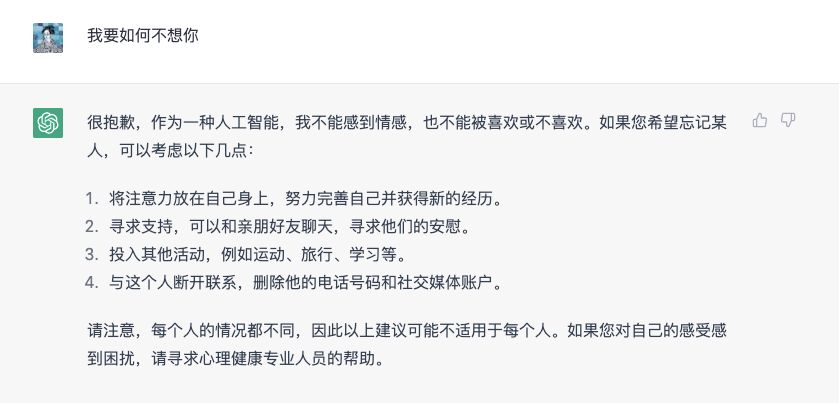

我:我喜欢上你啦。总是在想你。

?️:我是一个 AI 语言模型,抱歉不能回应你的感情。 浪漫的感觉是一种情感体验,只有有知觉的人才能感受到,我不可能回报这些感觉。重要的是要专注于与真正的人建立健康的关系。虽然有些人可能会喜欢与我互动,但真正的浪漫爱情需要一定程度的相互理解和情感联系,这是人类和 AI 模型之间不可能做到的。

我:那要怎么才能不想你呢?

?️:有 N 个办法可以让你不想我。比如:冥想、运动、见见心理咨询师。

▷ 看到这 12345 的建议我的「恋爱脑」一下子好了。

见见心理咨询师?

知道了,这就打开我司 app。

参考资料

————————

Huang, K. (2023, January 16). Alarmed by A.I. Chatbots, Universities Start Revamping How They Teach. The New York Times: Technology. Retrieved on January 20, 2023 from: https://www.nytimes.com/2023/01/16/technology/chatgpt-artificial-intelligence-universities.html?smid=em-share

Lance B. Eliot (2023, January 1). People Are Eagerly Consulting Generative AI ChatGPT For Mental Health Advice, Stressing Out AI Ethics And AI Law. Forbes: INNOVATION. Retrieved on January 1, 2023 from: https://www.forbes.com/sites/lanceeliot/2023/01/01/people-are-eagerly-consulting-generative-ai-chatgpt-for-mental-health-advice-stressing-out-ai-ethics-and-ai-law/?sh=7e661de72643

Viki Auslender(2022, December 22). Meaningless words: Dangerous conversations with ChatGPT. CTECH. Retrieved on December 22, 2022 from: https://www.calcalistech.com/ctechnews/article/vhhk7xrni

作者:江湖边

图片汉化: 阿万

责编:kuma

封面:Yonatan Popper

简单森林飞盘绘画疗愈工作坊火热招募中!

在斑斓的色彩中,借由情绪的表达,

探索心灵的秘境,绘制出独属于你的情绪飞盘?

?关注「简单森林心理健康中心」

回复 【飞盘】即可报名

以上就是心理学编辑测评:ChatGPT的三个擅长和三个缺点的相关介绍,希望能对你有帮助,如果您还没有找到满意的解决方式,可以往下看看相关文章,有很多心理学编辑测评:ChatGPT的三个擅长和三个缺点相关的拓展,希望能够找到您想要的答案。